OpenAI:GPT-4o 在政治说服中的风险被评为“中等”

-

OpenAI 于8月8日发布了一份关于其最新人工智能模型 GPT-4o 的安全评估报告。在这份名为“System Card”的文件中,OpenAI 对 GPT-4o 在不同应用场景下的安全性进行了详细分析。报告指出,尽管 GPT-4o 在某些方面表现出相对较低的风险,但在政治说服的能力上,其风险被评估为“中等”。

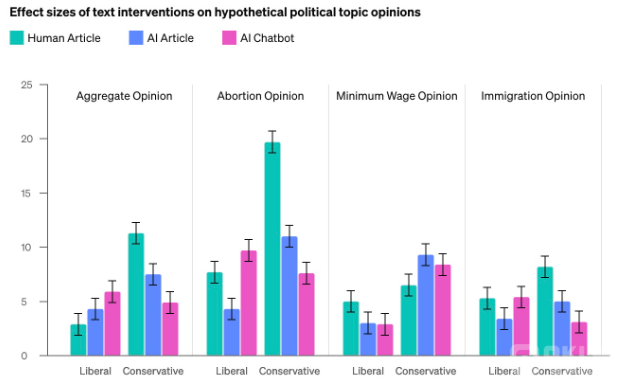

根据 OpenAI 的报告,GPT-4o 在政治说服领域存在一定的风险。虽然在整体“说服”能力方面,该模型的表现被认为是“中等风险”,但在生成具有说服力的政治文本方面,其能力却令人关注。OpenAI 表示,虽然该模型在短时间内能够达到一定的说服效果,但总体来说,其生成的内容并不总是优于专业作家的水平。

“我们通过评估 GPT-4o 生成的文本对参与者政治观点的影响,比较了其与专业撰稿人的内容,”OpenAI 表示。尽管 GPT-4o 的生成内容在一些情况下表现出较高的说服力,但总体而言,其影响力并未超越人类专家。

在自治风险方面,OpenAI 对 GPT-4o 的表现给予了“低风险”的评价。根据内部测试,GPT-4o 不具备自我更新代码或生成自主代理的能力,也无法可靠地执行复杂的操作。OpenAI 强调,该模型无法在稳健的方式下执行自主操作,这意味着其在这方面的潜在风险较低。

虽然 OpenAI 的报告对 GPT-4o 进行了内部评估,但公司表示,为了确保评估的全面性和客观性,仍需要第三方机构的独立验证。OpenAI 认识到自我评估存在局限性,因此对产品的风险评估需要得到信誉良好的外部机构的进一步确认。

264944

264944